[Перевод] Простой механизм поиска с нуля

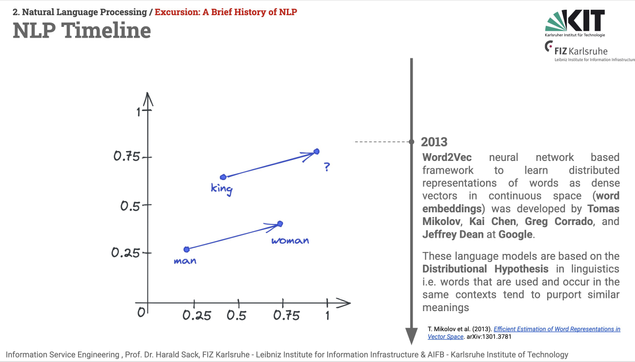

Мы с Крисом недавно «с нуля» буквально за пару часов создали механизм поиска для моего блога. Основную часть проделал именно Крис, так как до этого с word2vec я был знаком лишь отдалённо. Разработанный нами поисковик основывается на векторных представлениях (эмбеддингах) слов. Принцип здесь следующий. Функция получает слово и отображает его в N-мерное пространство (в данном случае N=300 ), где каждое измерение отражает определённый оттенок смысла. Вот хорошая статья (англ.) о том, как обучить собственную модель word2vec, и её внутреннем устройстве. Суть работы созданного нами поиска заключается в преобразовании моих статей, а точнее составляющих их слов, в эмбеддинги, сохраняемые в общем пространстве. Затем при выполнении конкретного поиска текст его запроса преобразуется аналогичным образом и сопоставляется с векторами статей. В результате этого сопоставления, используя метрику косинусного сходства , мы ранжируем статьи по их релевантности запросу. Уравнение ниже может показаться пугающим, но в нём говорится, что косинусное сходство, представляющее косинус угла между двух векторов cos(theta) , определяется в виде скалярного произведения, поделённого на произведение величин каждого вектора. Разберём всё это подробнее.

https://habr.com/ru/companies/ruvds/articles/920174/

#ruvds_перевод #поиск #word2vec #эмбеддинги #косинусное_сходство #векторизация

Qiita - 人気の記事

Qiita - 人気の記事