Qwen (@Alibaba_Qwen)

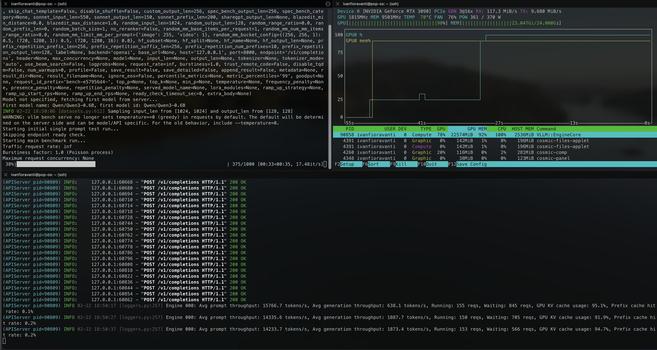

Qwen 3.5 Medium 모델 시리즈의 FP8 가중치가 공개되어 배포 준비 완료되었다는 공지입니다. vLLM과 SGLang에 대한 네이티브 지원이 포함되며 모델 카드에 예제 코드가 제공됩니다. FP8 정밀도로 워크플로 최적화가 가능하며 가중치는 Hugging Face에서 획득할 수 있다고 안내합니다.

Qwen (@Alibaba_Qwen) on X

🔥 Qwen 3.5 Medium Model Series FP8 weights are now open and ready for deployment! Native support for vLLM and SGLang. Check the model card for example code. ⚡️ Optimize your workflow with FP8 precision. 👇 Get the weights: Hugging Face:https://t.co/3MSb7miq68