Nick (@NickPlaysCrypto)

트윗은 $MOFLOW 개발자가 Cohere에서 풀스택을 담당하고 있으며 Cohere의 기업 가치가 70억 달러에 달하고 NVIDIA와 AMD가 전략적 투자자라는 내용을 전합니다. 투자와 인력 관련 뉴스로 AI 생태계의 자금·파트너십 동향을 보여줍니다.

Nick (@NickPlaysCrypto)

트윗은 $MOFLOW 개발자가 Cohere에서 풀스택을 담당하고 있으며 Cohere의 기업 가치가 70억 달러에 달하고 NVIDIA와 AMD가 전략적 투자자라는 내용을 전합니다. 투자와 인력 관련 뉴스로 AI 생태계의 자금·파트너십 동향을 보여줍니다.

AI is a tool, and its output is a reflection of its user.

Used well, it sharpens human thinking and expands potential.

Used poorly, it automates confusion and risk at scale.

And, all LLMs are vulnerable to prompt-injection.

#AI #LLM #PromptInjection #CyberSecurity #ArtificialIntelligence #MachineLearning #GPT #OpenAI #DataSecurity #ChatGPT #Privacy #Security #Claude #Gemini #Llama #Copilot #Anthropic #GoogleAI #MetaAI #Microsoft #MistralAI #xAI #Cohere #AISafety #AISecurity #Tech #Technology

Paul Couvert (@itsPaulAi)

대시보드에서 몇 분 만에 설정 가능하다는 안내: 계정 생성, Cohere 모델 선택, 확장 한도 설정으로 완료. 최신 Cohere 모델(Command, Embed, Rerank)을 지원하며 North와의 통합을 제공한다고 명시되어 개발·배포 편의성 강조.

Setup takes minutes in the dashboard: 1. Create your account here: https://t.co/qTRe1Jckmo 2. Pick your Cohere models 3. Set scaling limits Done. Supports all latest Cohere models (Command, Embed, Rerank) and integrates seamlessly with North. (Thanks @cohere for the

Paul Couvert (@itsPaulAi)

Model Vault가 퍼블릭 API(쉬움·불안정한 지연·레이트 제한)와 셀프호스팅(비용·복잡성)의 트레이드오프를 해소한다고 주장. 버스티한 에이전트 워크로드에 대한 탄력적 확장과 99.9%+ 가용성 제공 등 인프라 측면의 장점을 강조.

That’s really good because we currently have a tradeoff: Public APIs = easy but unpredictable latency + rate limits Self-hosting = total control but insane cost and complexity Model Vault kills that tradeoff, you get: - Elastic scaling for bursty agentic workloads - 99.9%+

Paul Couvert (@itsPaulAi)

Cohere의 Model Vault를 통해 사용자가 자신의 기기를 관리하지 않아도 AI 프라이버시를 확보할 수 있게 되었다는 발표. 완전 격리 환경 제공(단일 테넌시, 공유 데이터/GPU 없음)과 사용자 인프라 불필요로 사실상 무제한 확장이 가능하다고 설명.

So you can finally get AI privacy without managing your own machine You can create a fully isolated environment for your AI using Model Vault from Cohere that is: - Single-tenancy (no shared data or GPUs) - Effectively unbounded scaling w/ no user-managed infrastructure -

🎯 Zero accuracy loss - preserves what matters: errors, anomalies, high-scoring items & query-relevant content using BM25/embedding similarity

✅ Full provider support: #OpenAI, #Anthropic, #Google, #Cohere, #Mistral & #LiteLLM with exact token counting

📈 Performance: Search results (1000 items) 45K→4.5K tokens (90%), Log analysis 22K→3.3K tokens (85%), API responses 15K→2.25K tokens (85%)

fly51fly (@fly51fly)

논문 'SimMerge: Learning to Select Merge Operators from Similarity Signals'은 유사성 신호를 이용해 모델 병합에 사용할 merge 연산자를 학습적으로 선택하는 방법을 제안합니다. O. Bolton 등(Cohere·Google) 저자이며 arXiv에 공개되어 모델 병합과 파라미터 통합 관련 연구 및 MLOps 실무에 영향을 줄 수 있습니다.

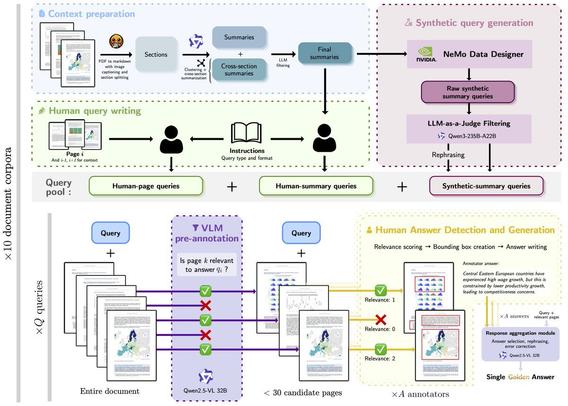

Manuel Faysse (@ManuelFaysse)

ViDoRe V3 논문 공개: AI 에이전트와 12,000시간 이상의 인간 주석을 활용해 '현실적인' 검색(retrieval) 벤치마크를 확장한 방법을 상세히 설명. V3 점수는 이미 Cohere와 Alibaba_Qwen의 최근 Visual Document Retrieval 릴리스에서 보고되었으며, 관련 논문은 arXiv에 게시됨.

The ViDoRe V3 paper is out! We detail how we scaled *realistic* retrieval benchmarking using AI agents and >12k hours of human annotation. V3 scores are already reported in recent Visual Document Retrieval releases from @cohere @Alibaba_Qwen ! https://t.co/9NrGmS3ZfK

30. A US federal district court just ruled that paraphrases or summaries by the #AI tool #Cohere might infringe publisher copyrights on the original full texts.

https://copyrightlately.com/court-rules-ai-news-summaries-may-infringe-copyright/

Here's the Nov 17 decision by the federal district court for the Southern District of NY.

https://www.courtlistener.com/docket/69636122/59/advance-local-media-llc-v-cohere-inc/

PS: This could undermine my thesis in this thread. But it doesn't undermine it yet. As I pointed out in the second post, "If a paraphrase doesn't use the original expression or track it too closely, then it doesn't infringe. If it does track the original too closely, it might count as a derivative work." The question in this case is whether some Cohere summaries were too close to the originals. Cohere lost a motion to dismiss, and now the court will investigate the "substantial similarity" claims on the merits. If the publishers win, we'll learn more about where the line is, not that there is no line.