➤ 模型上下文協議為何能脫穎而出?

✤ https://www.stainless.com/blog/mcp-is-eating-the-world--and-its-here-to-stay

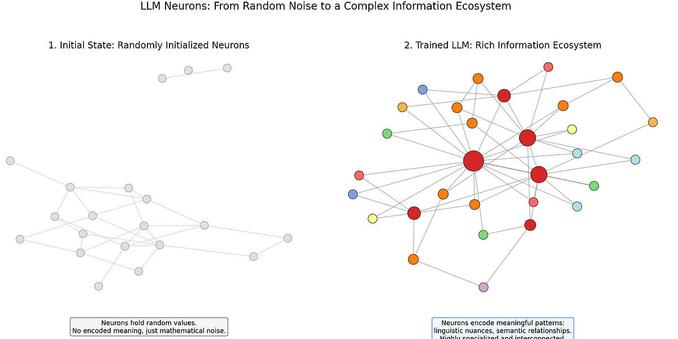

本文探討了模型上下文協議 (MCP) 迅速普及的原因。儘管 MCP 並非革命性技術,但其適時、簡潔和完善的設計,使其在大型語言模型 (LLM) 領域中脫穎而出。文章分析了 MCP 相較於過去類似嘗試的優勢:模型能力的提升、協議本身的優良性、完善的工具支援以及強勁的發展勢頭。MCP 提供了一個標準化的界面,簡化了工具與 LLM 的整合,降低了開發門檻,並促進了生態系統的蓬勃發展。文章預測 MCP 將在 AI 領域扮演更重要的角色,並可能影響未來 API 設計的思維方式。

+ 這篇文章很清楚地解釋了 MCP 為什麼會這麼火紅,而且它解決了之前類似技術的痛點。對於想了解這個新技術的人來說,是一篇很好的入門文章。

+ 我一直對 AI 工具整合感到困擾,這篇文章讓我知道了 MCP 可以簡化這個過程。期待看到更多基於 M

#人工智慧 #大型語言模型 #技術趨勢