Ollama 與 llama.cpp 的恩怨 (?)

M4 の MacBook Air でローカルLLM(2種): MLX版と公式の GGUF版の「Jan-v1-4B」をそれぞれ軽く試す(MLX LM と LM Studio を利用)

https://qiita.com/youtoy/items/dc8818981b7baff5dc08?utm_campaign=popular_items&utm_medium=feed&utm_source=popular_items

➤ Ollama 平臺 GGUF 模型運行問題追蹤

✤ https://github.com/ollama/ollama/issues/11714

本文記錄使用者在 Ollama 平臺上運行 gpt-oss 20b 模型時遇到的問題。與原始模型順利運行不同,GGUF 格式的模型出現了 tensor 類型錯誤,初步懷疑是 ggml 依賴庫需要更新,尤其提及 llama.cpp 項目。雖然在 llama.cpp 本身能夠正常運行 GGUF 模型,但問題仍然存在於 Ollama 環境。

+ 感覺是 Ollama 的 ggml 庫版本太舊了,需要更新一下。

+ 樓主是在哪個系統上跑的?我這邊有時也會遇到類似問題,但換個版本就好了。

#軟體錯誤 #模型運行 #GGUF 格式

Русскоязычные LLM для вызова инструментов, переводов и финансовой аналитики

🧠 Русскоязычные LLM для вызова инструментов, переводов и финансовой аналитики Подборка моделей, которые действительно позволяют отказаться от OpenAI и вести разработку в закрытом контуре без подключения к интернету 🔌

https://habr.com/ru/articles/920400/

#typescript #javascript #python #llm #ai #openai #grok #agents #tensorflow #gguf

Ускорение DeepSeek-R1 с подвохом: Когда токены в секунду врут о реальной скорости

Токены летят быстрее, а результат — медленнее: парадокс квантизации DeepSeek-R1. Замеры 4 версий модели доказали: уменьшение размера ускоряет генерацию отдельных токенов, но что происходит с общим временем ответа?

https://habr.com/ru/articles/919452/

#deepseek #deepseek_r1 #deepseek_r10528 #ai #llm #llmмодели #gguf #кодогенерация #local_ai #llamacpp

Локальный DeepSeek-R1: Когда скорость улитки – не приговор, а точка старта

Локальный DeepSeek-R1-0528 на скромном железе? Реально. Со скоростью улитки? Первоначально – да. Но итог моего эксперимента: эту 'улитку' можно заставить работать вдвое быстрее.

https://habr.com/ru/articles/916966/

#deepseek #ai #llm #local_ai #epyc #deepseek_r1 #deepseek_v3 #llamacpp #huggingface #gguf

Локальный DeepSeek-R1: Когда скорость улитки – не приговор, а точка старта

Локальный DeepSeek-R1-0528 на скромном железе? Реально. Со скоростью улитки? Первоначально – да. Но итог моего эксперимента: эту 'улитку' можно заставить работать вдвое быстрее.

https://habr.com/ru/articles/916966/

#deepseek #ai #llm #local_ai #epyc #deepseek_r1 #deepseek_v3 #llamacpp #huggingface #gguf

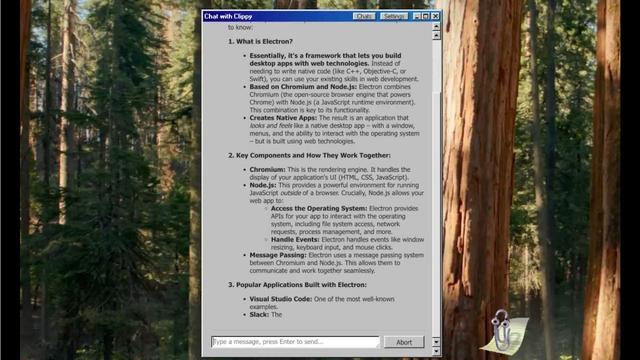

Microsoft Clippy Returns as AI Assistant, Empowered By LLMs You Can Run Locally on Your PC

#AI #Clippy #AIClippy #AIAssistants #LLMs #LocalAI #OpenSource #ElectronJS #LlamaCpp #GGUF #Gemma3 #Llama3 #Phi4 #Qwen3 #RetroTech #MicrosoftOffice #OnDeviceAI

Сравниваем скорость генерации LLM локально и по API

По ощущениям, на Хабре одна группа пользователей пользуется LLM локально, а другая - через внешние API. А третья еще не определилась, и у неё периодически возникают следующие вопросы: - Что будет, если запускать LLM на CPU вместо GPU? Сильно упадет скорость? - А как это от размера модели зависит? - А DeepSeek оригинальный очень большой - а можно его с диска подкачивать, если он в RAM не влезает? В общем, я пару раз отвечал на данные вопросы в комментариях - но поскольку я периодически натыкаюсь на них вновь и вновь, то решил сделать эту небольшую статью. TLDR : Я сделал небольшое HTML-приложение, которое наглядно дает ощущение скорости генерации в разных инсталляциях . Если непонятно, что там к чему - то лучше прочитать статью.

Qiita - 人気の記事

Qiita - 人気の記事