https://machinelearning.apple.com/research/normalizing-flows #NormalizingFlows #GenerativeModels #ResearchBuzzwords #AppleTech #MathematicalInnovation #HackerNews #ngated

https://machinelearning.apple.com/research/normalizing-flows #NormalizingFlows #GenerativeModels #ResearchBuzzwords #AppleTech #MathematicalInnovation #HackerNews #ngated

Normalizing Flows Are Capable Generative Models

https://machinelearning.apple.com/research/normalizing-flows

#HackerNews #NormalizingFlows #GenerativeModels #MachineLearning #AIResearch #DataScience

Apple odkrywa na nowo zapomnianą technikę AI do generowania obrazów – Normalizing Flows

Apple zaprezentowało dwa badania, w których reaktywuje mało znaną technikę AI – Normalizing Flows (NF), mogącą konkurować z popularnymi dziś modelami dyfuzyjnymi (np. Stable Diffusion) i autoregresyjnymi (np. GPT-4o).

Czym są Normalizing Flows? To modele, które uczą się przekształcać dane rzeczywiste (np. obrazy) w szum i odwrotnie, z możliwością dokładnego obliczania prawdopodobieństwa wygenerowanego obrazu – coś, czego nie potrafią modele dyfuzyjne.

Pierwsze badanie TarFlow łączy Normalizing Flows z architekturą Transformerów. Generuje obraz bez tokenizacji, operując bezpośrednio na wartościach pikseli. To redukuje utratę jakości typową dla modeli przekształcających obrazy w symbole tekstowe.

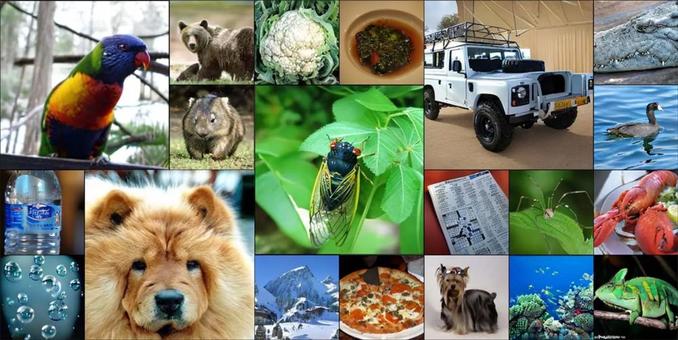

Obrazy o różnych rozdzielczościach wygenerowane przez modele TarFlow. Od lewej do prawej, od góry do dołu: obrazy 256×256 w AFHQ, obrazy 128×128 i 64×64 w ImageNet.

2 badanie STARFlow działa w przestrzeni latentnej – generuje uproszczony obraz, który dekoder przekształca w wysoką rozdzielczość. Model może być zasilany zewnętrznymi LLM-ami (np. Gemma), które interpretują polecenia tekstowe użytkownika, a STARFlow skupia się na szczegółach wizualnych.

Losowe próbki STARFlow na ImageNet 256 × 256 i 512 × 512.

Jak wygląda porównanie Apple z OpenAI?

GPT-4o generuje obrazy jako sekwencje tokenów (jak tekst), co daje uniwersalność, ale jest wolne i zasobożerne – wymaga pracy w chmurze.

STARFlow jest zoptymalizowany pod pracę lokalną (on-device) – szybszy i bardziej energooszczędny.

Apple stawia na wydajne, lokalne generowanie obrazów, idealne dla urządzeń mobilnych.

#AI #aiapple #AppleAI #appleai #appleml #applevsopenai #generatywnaSztucznaInteligencja #generowanieobrazów #gpt4o #normalizingflows #OpenAI #starflow #sztucznaInteligencja #sztucznainteligencja #tarflow #technologia #transformerai

Weekly Update from the Open Journal of Astrophysics – 26/04/2025

It’s Satuday morning once again, and time for another update of papers published at the Open Journal of Astrophysics. Since the last update we have published two papers, which brings the number in Volume 8 (2025) up to 44 and the total so far published by OJAp up to 279.

The first paper to report is “Approximating non-Gaussian Bayesian partitions with normalising flows: statistics, inference and application to cosmology” by Tobias Röspel, Adrian Schlosser & Björn Malte Schäfer (Universität Heidelberg, Germany) which was published on April 23rd 2025 in the folder Cosmology and NonGalactic Astrophysics. It is an introduction to normalizing flows – a machine learning technique for transforming distributions – and its application to the extraction of cosmological parameters from supernova data.

The overlay is here:

You can find the officially accepted version on arXiv here.

The other paper this week is “Dwarf Galaxies in the TNG50 Field: connecting their Star-formation Rates with their Environments” by Joy Bhattacharyya & Annika H.G. Peter (Ohio State University, USA) and Alexie Leauthaud (UC Santa Cruz, USA). This one was published on 24th April 2025 in the older Astrophysics of Galaxies and it studies dwarf galaxies with properties similar to the Large and Small Magellanic Clouds that form in different environments in the TNG50 simulation of the IllustrisTNG project.

The overlay is here:

and you can find the final accepted version on arXiv here.

That’s all for this week. I’ll have another update next Saturday.

#arXiv250101946v2 #arXiv250104791v3 #AstrophysicsOfGalaxies #Cosmology #CosmologyAndNonGalacticAstrophysics #DiamondOpenAccess #dwarfGalaxies #Illustris #MachineLearning #normalizingFlows #OpenJournalOfAstrophysics #TheOpenJournalOfAstrophysics

"Validation Diagnostics for SBI algorithms based on Normalizing Flows"

https://arxiv.org/abs/2211.09602

#SBI #bayesian #inference #MachineLearning #DeepLearning #NormalizingFlows

Validation Diagnostics for SBI algorithms based on Normalizing Flows

Building on the recent trend of new deep generative models known as Normalizing Flows (NF), simulation-based inference (SBI) algorithms can now efficiently accommodate arbitrary complex and high-dimensional data distributions. The development of appropriate validation methods however has fallen behind. Indeed, most of the existing metrics either require access to the true posterior distribution, or fail to provide theoretical guarantees on the consistency of the inferred approximation beyond the one-dimensional setting. This work proposes easy to interpret validation diagnostics for multi-dimensional conditional (posterior) density estimators based on NF. It also offers theoretical guarantees based on results of local consistency. The proposed workflow can be used to check, analyse and guarantee consistent behavior of the estimator. The method is illustrated with a challenging example that involves tightly coupled parameters in the context of computational neuroscience. This work should help the design of better specified models or drive the development of novel SBI-algorithms, hence allowing to build up trust on their ability to address important questions in experimental science.