Gemini umożliwia generowanie filmów z modelem Veo 2

Google ogłosiło wprowadzenie nowej funkcji w aplikacji Gemini, umożliwiającej użytkownikom Gemini Advanced generowanie 8-sekundowych filmów za pomocą modelu Veo 2.

Funkcja jest już dostępna, pozwala tworzyć klipy wideo w rozdzielczości 720p na podstawie tekstowych opisów. Model Veo 2 jest zintegrowany z aplikacją Gemini na urządzeniach mobilnych i w wersji przeglądarkowej.

Veo 2 is super fun to play with, and people have been creating some amazing videos with it. Its implicit understanding of the physics of the world is kind of mindblowing. Looking forward to seeing more people enjoy it now that it’s part of @GeminiApp! https://t.co/bMqLCmNHmd

— Demis Hassabis (@demishassabis) April 15, 2025

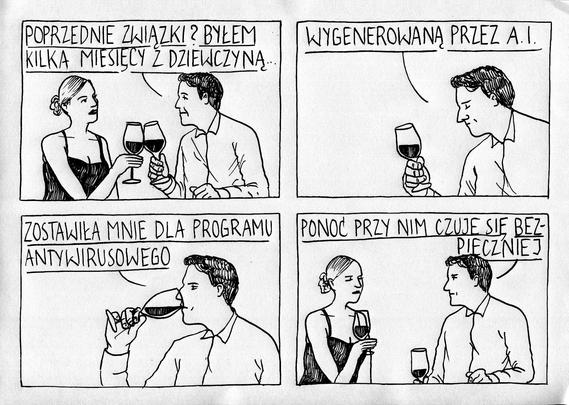

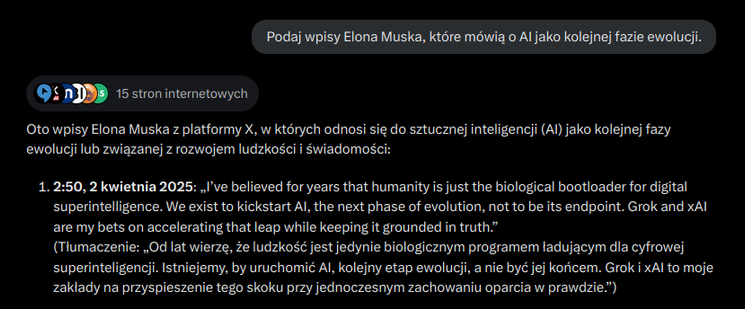

Aby wygenerować film, użytkownicy wybierają model Veo 2 z menu aplikacji Gemini i wprowadzają opis sceny, którą chcą stworzyć. Im bardziej szczegółowy prompt, tym większa kontrola nad efektem końcowym. Wyprodukowane filmy są zapisywane w formacie MP4 w proporcjach 16:9 i mogą być udostępniane w mediach społecznościowych, takich jak TikTok czy YouTube Shorts. Wszystkie klipy są oznaczane cyfrowym znakiem wodnym SynthID, wskazującym, że zostały stworzone przez sztuczną inteligencję.

Google podkreśla, że Veo 2 wyróżnia się zaawansowanym rozumieniem fizyki i ruchu ludzkiego, co pozwala na tworzenie realistycznych scen i płynnych animacji w różnych stylach. Funkcja jest obecnie ograniczona do generowania filmów na podstawie tekstu, ale firma zapowiada prace nad rozszerzeniem możliwości modelu.

Użytkownicy Gemini Advanced mogą korzystać z tej opcji w ramach subskrypcji Google One AI Premium, kosztującej 97,99 zł miesięcznie w Polsce. Nowa funkcja jest również dostępna w eksperymentalnym projekcie Google Labs o nazwie Whisk, gdzie użytkownicy mogą przekształcać obrazy w animacje za pomocą Veo 2. Wdrożenie rozpoczęło się 15 kwietnia i potrwa kilka tygodni, obejmując wszystkie języki obsługiwane przez Gemini, w tym polski. Google nie podało szczegółów dotyczących miesięcznych limitów generowania filmów, ale użytkownicy będą informowani o zbliżaniu się do limitu.

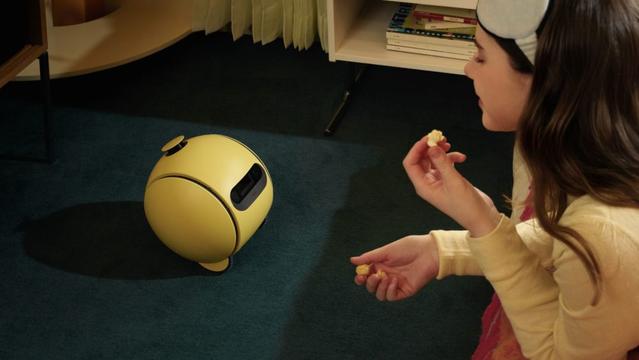

Wprowadzenie Veo 2 do Gemini jest kolejnym krokiem w rozwoju generatywnej sztucznej inteligencji Google, mającym na celu zwiększenie kreatywnych możliwości użytkowników. Firma zachęca do testowania nowej funkcji i dzielenia się opiniami, które pomogą w dalszym udoskonalaniu modelu. Czy Veo 2 pojawi się również w wersji bezpłatnej Gemini? Na ten temat Google milczy. Oczywiście powyższe ilustracje to stopklatki z przykładowych klipów wygenerowanych przez debiutującą funkcję w Gemini Advanced.

Google Cloud prezentuje przełomowe rozwiązania AI na Next ‘25

#AI #Gemini #generowanieWideo #Google #news #sztucznaInteligencja #Veo2