ELT процесс в архитектуре Data lakehouse на базе open-source (kafka, dagster, s3+iceberg, trino, clickhouse и DBT)

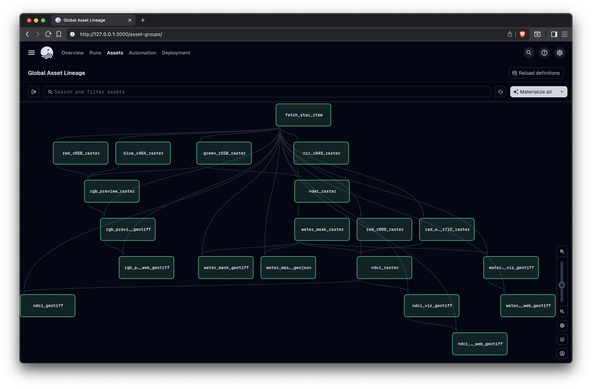

К нам обратился один из крупнейших строительных холдингов России (ГК компаний из 10+ юридических лиц) с потребностью в сборе всех данных с филиалом, анализе и визуализации на дашбордах. При входе на проект аналитической инфраструктуры у компании почти не было, только множество учетных систем без централизованного хранилища данных. Объем проекта был непонятен, «аппетит приходит во время еды». Важная особенность проекта — полностью закрытый контур с доступом через терминальные решения. Было решение выбрать архитектуру Data Lakehouse на open source стеке, основой которого стали — kafka, dagster, s3+iceberg, trino, clickhouse и DBT. В результате получилось более 1000 моделей DBT, 1 тб сжатых данных, и объем продолжает расти. Из потребителей данных — бизнес системы, Power BI отчеты, аналитики и дата‑инженеры, веб‑приложения, MDX‑кубы. Методология ведения проекта Scrum, команда DWH‑инженеров 11 человек и greenfield‑разработка.

https://habr.com/ru/articles/931282/

#dbt #ymlфайл #datalakehouse #data_engineering #etlпроцессы #open_source #trino #clickhouse #dagster

DevelopersIO

DevelopersIO