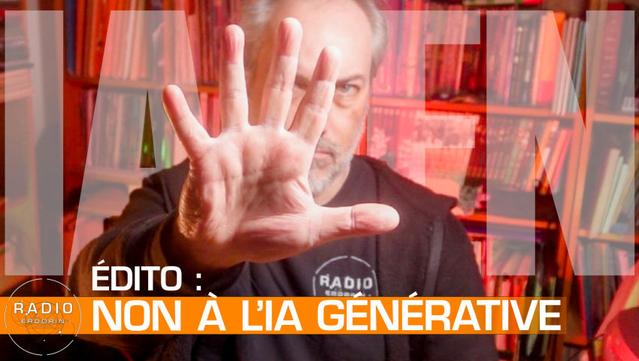

#Éditorial : non à l’intelligence artificielle générative

Pour ce premier "édito" sur Radio-Erdorin, @Stéphane "Alias" Gallay revient sur sa résolution pour 2026 : boycotter les contenus avec de l'intelligence artificielle générative : #^https://videos.pair2jeux.tube/w/4RkCo6FDuUh84Y2HiM6rKs

#ia #iagen #iagénérative #numerique