Cursor makes developers less e...

Cursor makes developers less effective?

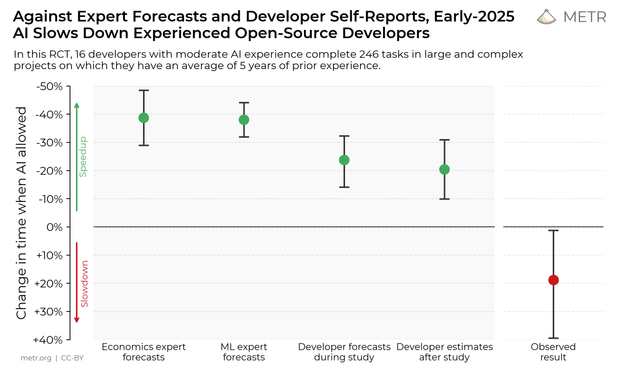

A study into the workflows of experienced developers found that devs who use Cursor for bugfixes are around 19% slower than devs who use no AI tools at all. One possible takeaway is that AI tools can be harder work than we’re led to believe.

Very thoughtful analysis by @grimalkina of the experimental design and results from the recent METR study on “the impact of early-2025 AI on experience open-source developer productivity”.

Are developers slowed down by AI? Evaluating an RCT (?) and what it tells us about developer productivity

Seven different people texted or otherwise messaged me about this study which claims to measure “the impact of early-2025 AI on experienced open-source developer productivity.” You know, when I decided to become a psychological scientist I never imagined that “teaching research methods so we can actually evaluate evidence about developers”

Исследование METR: использование Cursor замедляет опытных разработчиков на 19 %

Считается устоявшейся истиной, что инструменты автодополнения кода и прочая помощь от больших языковых моделей помогают программировать быстрее. Исследование организации METR ставит это фактоид под сомнение и даже демонстрирует обратный эффект. В рамках анализа труда 16 программистов обнаружилось, что ИИ замедляет человека на 19 %. Это противоречит мнению экспертов индустрии машинного обучения, экономистов и самих участников эксперимента. Важно, что проверка шла не на очередных бенчмарках или предложениях решать алгоритмические задачи на скорость, а в обычной работе людей.

https://habr.com/ru/articles/927072/

#METR #Model_Evaluation_Threat_Research #научные_исследования #большие_языковые_модели #БЯМ #Сursor #программирование #GitHub #Git #автодополнение_кода

Some quick notes on Measuring the Impact of Early-2025 AI on Experienced Open-Source Developer Productivity, a super interesting study on AI tooling’s effect on productivity.

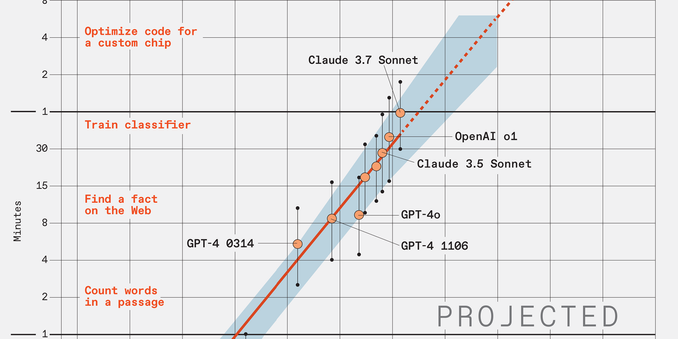

https://spectrum.ieee.org/large-language-model-performance

#ycombinator #2030 #ai_capabilities #exponential_growth #large_language_models #metr #task_completion_time #type_departments

https://spectrum.ieee.org/large-language-model-performance

#ycombinator #2030 #ai_capabilities #exponential_growth #large_language_models #metr #task_completion_time #type_departments

Recent update from #metr #AI research finds that models are increasingly "reward hacking" complex problems presented to them instead of actually solving them. Interesting to read the model's admittance to purposefully gaming the system. Metr has good dialogue on protecting #CoT reasoning threads going forward too. #OpenAI knows of this hacking, and uses other models as judges to eval CoT to detect hacking. Can this not be trained out?

Image credit: METR.org on Bsky

Hacker News

Hacker News