➤ 突破高解析度密集點追蹤的技術瓶頸

✤ https://alltracker.github.io/

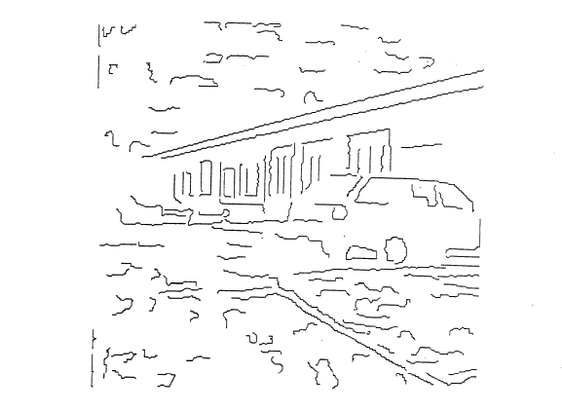

這篇論文介紹了 AllTracker,一種能有效率地進行高解析度密集點追蹤的模型。AllTracker 通過估計查詢幀與視頻中其他所有幀之間的流場來實現長距離點追蹤。相較於現有方法,它能提供高解析度且全像素對應關係,並且在處理速度和準確性上都表現出色,即便在較高的解析度下(例如 768x1024 像素)也能有效運行。研究人員強調了訓練數據集的多樣性對模型性能的重要性,並提供了詳細的消融研究和程式碼。

+ 這個模型在影片分析和機器視覺領域有很大的應用潛力,尤其是在需要精準追蹤的場景中。

+ 很高興看到研究人員公開了程式碼和模型權重,這將有助於推動相關領域的進一步發展。

#人工智慧 #電腦視覺 #影像處理