➤ LLM 的盲點:缺乏世界模型的根本性缺陷

✤ https://garymarcus.substack.com/p/generative-ais-crippling-and-widespread

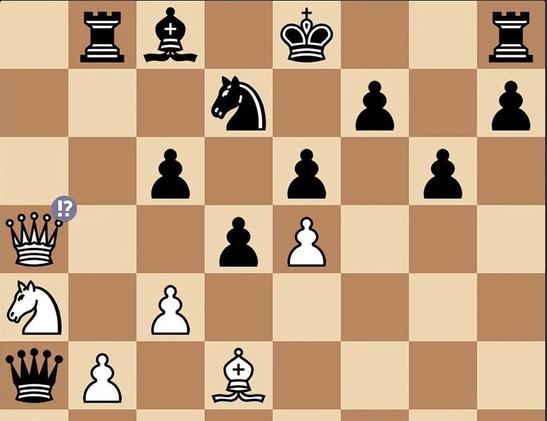

本文探討了生成式 AI(尤其是大型語言模型 LLM)在建立可靠世界模型方面的根本性缺陷。作者指出,LLM 在推理方面的失敗只是更深層問題的一部分,即它們缺乏像人類和動物那樣,能追蹤、更新和理解世界狀態的認知模型。儘管 LLM 在統計分析方面取得了進展,但缺乏明確的世界模型是其核心弱點,這阻礙了它們真正理解並有效推理的能力。作者透過棋局、兒童故事等例子,說明瞭世界模型在認知和 AI 系統中的重要性,並呼籲 AI 研究者重新重視傳統的建模方法。

+ 這篇文章點出了我一直以來對 AI 發展感到擔憂的地方。數據再多,沒有對世界的理解,AI 就只會是鸚鵡學舌。

+ 作者將 LLM 的問題與人類認知模型做了很好的類比,讓我更明白 AI 目前發展的瓶頸在哪裡。 難怪 AI 總是出錯。

#人工智慧 #大型語言模型 #世界模型 #認知模型