An alle, die gerne KI / AI / LLM tools (ChatGPT, Copilot, etc.) verwenden oder nur zum Spaß damit herum spielen, bitte nehmt euch die 5 Minuten und lest euch das durch:

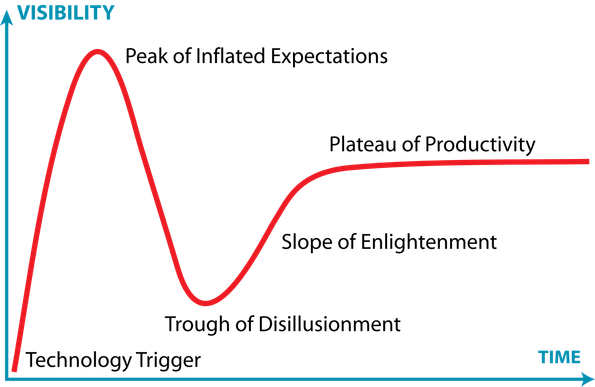

https://blog.campact.de/2025/05/ki-randaliert-im-netz-admins-halten-dagegen/

Das ist nicht übertrieben, nicht gelogen, nicht schlecht erfunden. Das ist die Realität, mit der wir (als Admins) tagtäglich kämpfen, die regelmäßig zu Aufwänden (und Ausfällen!) führt.