@Giliell

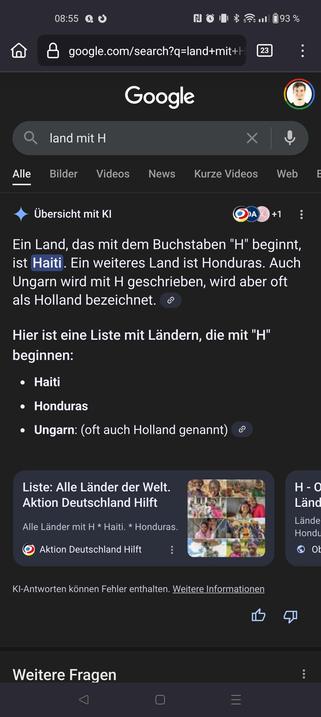

Ich habe den Hinweis, dass KI-Antworten *Fehler* enthalten können in meinem Screenshot extra noch mal markiert, stand aber im Urpsrungspost auch schon da.

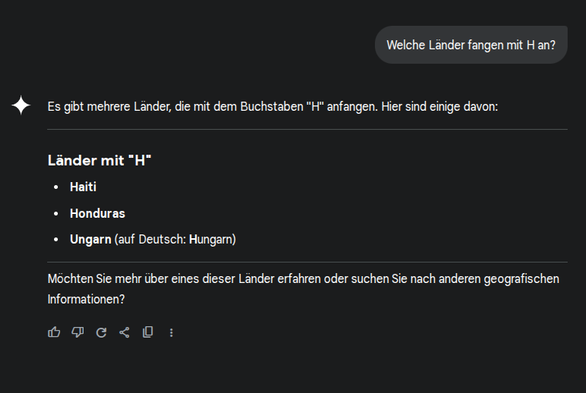

Außerdem dann noch der Hinweis, wenn man auf den Link klickt:

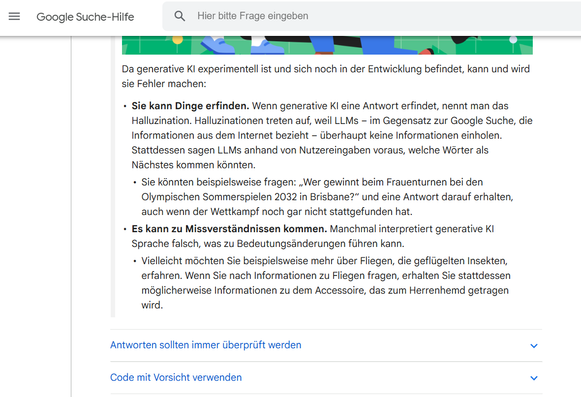

"Da generative KI experimentell ist und sich noch in der Entwicklung befindet, kann und wird sie Fehler machen:

Sie kann Dinge erfinden. Wenn generative KI eine Antwort erfindet, nennt man das Halluzination. Halluzinationen treten auf, weil LLMs – im Gegensatz zur Google Suche, die Informationen aus dem Internet bezieht – überhaupt keine Informationen einholen. Stattdessen sagen LLMs anhand von Nutzereingaben voraus, welche Wörter als Nächstes kommen könnten.

Sie könnten beispielsweise fragen: „Wer gewinnt beim Frauenturnen bei den Olympischen Sommerspielen 2032 in Brisbane?“ und eine Antwort darauf erhalten, auch wenn der Wettkampf noch gar nicht stattgefunden hat.

Es kann zu Missverständnissen kommen. Manchmal interpretiert generative KI Sprache falsch, was zu Bedeutungsänderungen führen kann.

Vielleicht möchten Sie beispielsweise mehr über Fliegen, die geflügelten Insekten, erfahren. Wenn Sie nach Informationen zu Fliegen fragen, erhalten Sie stattdessen möglicherweise Informationen zu dem Accessoire, das zum Herrenhemd getragen wird."

https://support.google.com/websearch/answer/13954172?sjid=7615247881894390934-EU#zippy=%2Cso-k%C3%B6nnen-sie-ihre-daten-kontrollieren%2Cki-kann-und-wird-fehler-machen

Und das sind nur die (schöngefärbten) Hinweise von google in eigener Sache...

@Nekator @NatureMC @unionista @kinghaunst